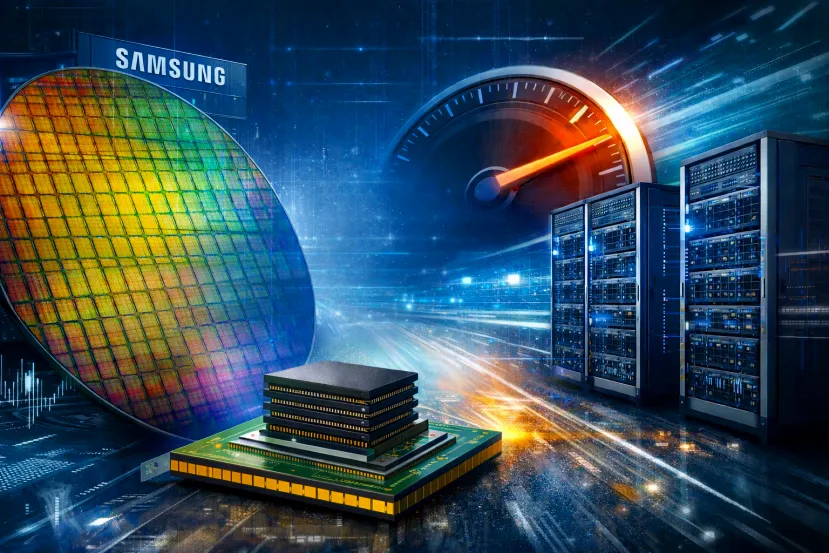

Samsung pisa el acelerador con HBM4: más DRAM al mes y una señal clara para la industria de la IA

por Manuel NaranjoEn el debate sobre IA se habla mucho de GPUs, pero la memoria es la otra mitad del músculo. Si el acelerador calcula rápido y la memoria no le alimenta datos con la misma velocidad, el sistema se queda esperando. Y esperar, en un centro de datos, es dinero evaporándose. Por eso el movimiento de Samsung alrededor de HBM4 es más importante de lo que parece: la compañía planea aumentar la producción de DRAM destinada a esta nueva generación de memoria de alto ancho de banda.

El salto de escala, tal y como se está manejando, es contundente. El año pasado se levantó una línea de DRAM “1c” capaz de alrededor de 60.000 a 70.000 obleas al mes. Si el plan se confirma, la producción mensual se acercaría a las 200.000 obleas. Esa cifra no se anuncia para quedar bien: es una apuesta por volumen y por demanda sostenida.

Por qué HBM4 se ha convertido en un asunto estratégico

HBM (High Bandwidth Memory) no es una DRAM corriente. Se apila y se integra de forma muy cercana al procesador gráfico o al acelerador, con el objetivo de entregar un ancho de banda enorme y una eficiencia mejor que la de soluciones más tradicionales. En cargas de IA, eso se traduce en algo inmediato: menos cuellos de botella y más rendimiento útil.

HBM4 llega en un momento en el que el mercado ya no discute si la IA se va a usar, sino cuánta y dónde. Entrenamiento de modelos, inferencia en tiempo real, análisis de vídeo, asistentes internos en empresas… Todo eso multiplica el número de chips desplegados y, por tanto, multiplica la demanda de memoria “a la altura”.

Una pista clave: 4 nm a pleno rendimiento para el “base die”

Un detalle que llama la atención es que la línea de 4 nm en Pyeongtaek S5 estaría funcionando a plena capacidad y se menciona como la que produce el “base die” para HBM4. Este tipo de información suele aparecer cuando una fase deja de ser experimento y pasa a ser preparación industrial.

En HBM, el “base die” y el empaquetado no son un trámite. La memoria apilada necesita un proceso muy fino para que el conjunto rinda, disipe calor y cumpla con las exigencias de estabilidad que piden los grandes compradores. Si esa parte ya está “a tope”, la lectura es que Samsung está alineando cadena completa, no solo una pieza suelta.

De 70.000 a 200.000 obleas: lo que implica el cambio de escala

Triplicar capacidad potencial no es ajustar un tornillo. Es decidir que quieres estar bien colocado cuando el mercado pase del “piloto” a los despliegues masivos. En semiconductores, aumentar obleas al mes significa invertir, asegurar materiales y asumir que vas a necesitar pedidos para llenar esa capacidad.

¿De dónde sale esa demanda? De la carrera de la IA, sí, pero también de la necesidad de mejorar el rendimiento por servidor. Cuando una empresa compra aceleradores, quiere sacar el máximo por cada euro: más modelos en paralelo, más inferencias por segundo, menos consumo por tarea. HBM de nueva generación ayuda a ese objetivo y por eso los contratos de memoria se negocian casi como si fuesen suministro energético.

El “este mes” y la lista de clientes: el dato que más pesa

La información también apunta a que Samsung se estaría preparando para suministrar HBM4 a clientes principales como NVIDIA y AMD “este mes”. Ese “este mes” no significa necesariamente volúmenes gigantes desde el minuto uno, pero sí sugiere que la fase de validación y entrega de lotes iniciales está madura.

En este mercado, entrar en la cadena de suministro de grandes aceleradores funciona como una acreditación. No solo se vende memoria: se gana confianza y se abre la puerta a más proyectos. Y, a partir de ahí, el siguiente escalón es el de los contratos de volumen, donde el vencedor no es quien tiene el mejor PowerPoint, sino quien entrega de forma consistente.

Por qué esto te afecta aunque no tengas un centro de datos

HBM4 no se queda en un CPD. Si la memoria de alto ancho de banda escasea o se encarece, el coste de entrenar y servir modelos sube, y eso se filtra a servicios de IA: suscripciones más caras, límites más duros o despliegues más lentos. Si, al contrario, la oferta crece y la competencia se aprieta, la IA se abarata y llega a más usos cotidianos.

En resumen: el movimiento de Samsung es una señal clara de que HBM4 ya no es una promesa lejana. Es una pieza central en la siguiente oleada de infraestructura de IA, y la industria se está preparando para consumirla a gran escala.

Lo próximo será ver cómo evolucionan los rendimientos por oblea y si el empaquetado acompaña sin cuellos de botella. En HBM, fabricar es importante, pero fabricar bien y a tiempo es lo que marca quién se queda con los pedidos grandes.

Fin del Artículo. ¡Cuéntanos algo en los Comentarios!